제프리 힌튼 토론토대 컴퓨터공학과 교수(76)가 최근 일본 니혼게이자이신문과 인터뷰에서 “앞으로 10년 안에 인간을 죽이는 로봇 무기가 등장할 것으로 본다”라고 말해 큰 반향을 일으켰습니다. 물론 그는 “세계 각국이 힘을 모아 로봇 무기를 규제할 수 있을 것”이라고 했지만, 인공지능(AI)의 아버지 격인 힌튼의 발언은 듣는 사람을 오싹하게 만듭니다. 힌튼이 AI가 언젠가 인류를 해칠 수도 있다고 한 발언을 한 것은 이번이 처음이 아닙니다. 딥러닝과 인공신경망의 창시자인 그는 왜 AI가 만들어낼 어두운 미래를 예견하게 된 것인지 알아보겠습니다.

1. AI 4대 천왕들의 아버지

힌튼은 AI 학계의 대부입니다. 일단 나머지 ‘AI 4대 천왕’인 얀 르쿤 뉴욕대 교수(63), 요수아 벤지오 몬트리올대 교수(59), 앤드류 응 스탠퍼드대 교수(47)도 모두 힌튼의 영향을 받았습니다. 벤지오가 신경망을 이용한 AI 연구를 시작하게 된 건 석사 과정 중이었던 1985년 힌튼의 논문을 읽고 나서였습니다. AI 신경망 분야는 당시 비주류 분야였는데, 벤지오는 힌튼의 논문을 읽고선 일생을 걸 만한 분야라고 생각했다고 합니다.

르쿤은 자신이 발명한 나선형 신경망(CNNs) 연구 성과가 힌튼 덕분이라고 말했습니다. 나선형 신경망은 인간의 뇌 구조를 본뜬 인공신경망 모델인데, 컴퓨터의 이미지 인식 및 분석 능력에 비약적인 발전을 가져왔습니다. 힌튼이 고안한 역전파(backpropagation) 알고리즘 덕분에 나선형 신경망을 구축할 수 있었다는 얘깁니다. 역전 파는 인공신경망을 통해 하위로 전달된 정보가 최종 결과와 얼마나 차이가 있는지 역방향으로 피드백을 주는 개념입니다. 정보값이 전후로 오가는 과정을 통해 컴퓨터는 시행착오를 줄이며 고도의 결과를 도출해 내게 됩니다. 역전파 알고리즘이 없다면 입력된 정보를 기반으로 단순히 결괏값이 도출되겠지만, 피드백 과정을 거치며 학습을 할 수 있게 된 것입니다. 이 같은 개념을 고안해 낼 수 있었던 것은 힌튼이 컴퓨터공학자인 동시에 인지심리학자인 점과 무관하지 않아 보입니다.

응 역시 힌튼의 연구에서 많은 영감을 받았습니다. 응은 2012년 구글의 딥러닝 팀인 구글브레인 설립에 참여했는데, 구글브레인은 유튜브 영상에서 고양이를 인식할 수 있는 대규모 딥 신경망의 개발 프로젝트를 진행했습니다. ‘Cat Brain Project’로 불린 프로젝트입니다. 이 프로젝트는 힌튼이 일궈놓은 딥러닝 연구 성과에 기반해 시작됐고, 이후 힌튼도 구글에 참여하면서 관련 프로젝트에서 많은 기여를 했습니다.

응은 딥러닝을 대중화하는데 큰 기여를 한 인물로 평가받는데, 결국 힌튼의 연구성과를 실생활에서 적용할 수 있는 것으로 전환시킨 공로가 큽니다. 실제 응은 중국 최대 검색엔진 기업인 바이두에 최고 과학자로 영입되고, 인공지능 교육플랫폼인 deeplearning.ai를 설립하며 딥러닝 활성화에 앞장섰는데, 여기에서 일군 성과를 통해 이전까지 AI 학계 내 팽배했던 인공신경망에 대해 부정적인 기류를 완전히 전환하는데 큰 기여를 했습니다. 마치 힌튼이 선구적인 제품을 개발한 기술자라면, 응은 이를 상품화한 마케팅 책임자라고 할 수 있을 겁니다.

2. 구글 합류했다가 급퇴사…AI의 아버지에서 위기론자로

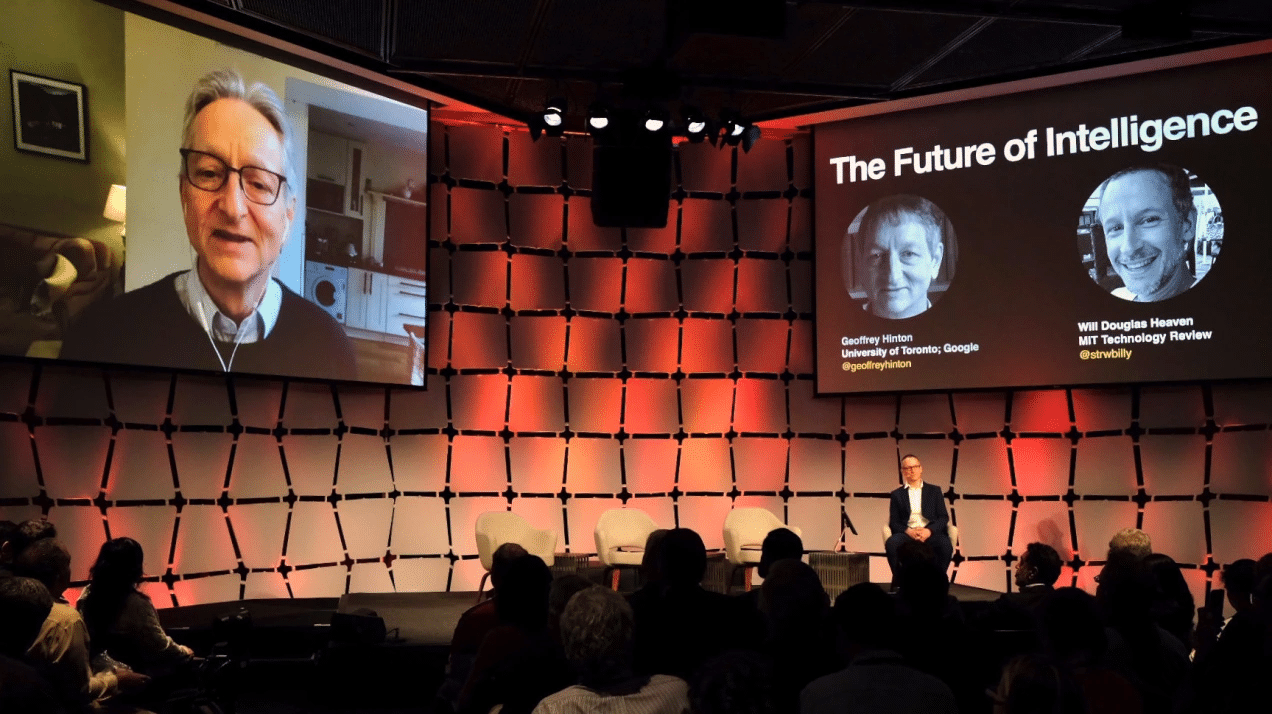

AI 분야의 개척자라고 할 수 있는 힌튼은 지난해 돌연 10년 넘게 몸담았던 구글에서 퇴사하며 AI 위기론자로 변신했습니다. 지난해 5월 퇴사 당시 힌튼은 “생성 AI로 인한 가짜 이미지와 텍스트가 너무 많아졌다. 앞으로 인간은 진실과 거짓을 구분하지 못하는 세상을 마주하게 될 것이다. 이 점이 가장 두렵다”며 퇴사의 이유를 밝혔습니다. 구글 AI 사업을 이끌면서 AI의 위험성을 이야기할 경우 회사 이익에 반할 수 있으니, 회사에서 나와 학자 신분으로 AI의 위험성에 대해 보다 자유롭게 이야기하겠다는 것입니다. AI의 핵심을 가장 잘 꿰뚫고 있는 인사이니 AI의 무분별한 개발이 초래할 디스토피아를 더 이상 묵과할 수 없다고 판단했던 것입니다. 그러다가 급기야 최근 니혼게이자이와의 인터뷰에서 킬러 로봇의 등장까지 예견하고 나서게 된 것입니다.

“AI에게 목표를 주면 해결책으로 인간에게 나쁜 방법을 찾아낼지도 모릅니다. 예를 들어 AI에게 기후변화를 막도록 지시하면 이 목적 달성을 위해 인간을 배제하는 게 필요하다고 생각하고서 실행에 옮길 위험성이 걱정됩니다.”

-니혼게이자이신문 인터뷰 中

그가 AI가 인류를 위협할 수 있다고 생각하는 가장 큰 이유는 언어와 감정이 후천적으로 취득될 수 있다고 생각하기 때문입니다. AI가 인공신경망을 통해 언어를 익히고 감정과 감각을 익힐 경우 의도와 의지를 갖게 될 수 있다는 것입니다.

“생성형 AI의 기반인 거대 언어 모델은 우리와 마찬가지로 말을 이해하고 있다고 생각합니다. AI가 농담을 이해하는지를 보면 알 수 있습니다. 2022년 구글이 개발한 언어모델(PaLM)에 의한 챗봇을 상대로 농담을 설명해 달라고 했을 때 챗봇은 그 농담이 왜 재미있는지 모두 설명했습니다, 철학자들 사이에서는 인간이 언어를 사용하는 기능을 선천적으로 갖고 있다는 주장이 있지만 그건 틀린 얘기입니다. 언어는 태어난 뒤에 학습하는 후천적인 것입니다. 주관적인 경험이라는 관점에서 보면 AI는 인간과 같은 감각도 가질 수 있는 것입니다.”

힌튼의 이 같은 생각은 갑자기 돌출될 것은 아닙니다. 2000년대 그의 문하에서 공부한 많은 인사들이 AI에 대한 힌튼의 관점을 공유하고 있습니다. 일례로 토론토대에서 컴퓨터공학 석·박사학위를 취득한 일리야 수츠케버 오픈 AI 수석과학자(38)도 대표적인 AI 규제론자입니다. 그는 작년 여름 오픈 AI 내 AI얼라인먼트팀(alignment)을 신설하고, AI가 가져올 여러 부작용과 해악에 대해 대비하는데 주력하고 있습니다. 작년 11월 산업계 최대 이슈였던 오픈 AI 이사회의 샘 올트먼 축출에 수츠케버가 동참했던 것도 AI 개발론과 규제론의 충돌 과정에서 수츠케버가 규제론에 손을 들었기 때문이라고 보는 시각이 많습니다.

힌튼의 이 같은 생각은 “산업 초기 단계인 AI에 대한 규제 논의는 너무 이르다”라고 말하는 일련의 그룹들과 충돌하며 갑론을박이 오가는 상황입니다. 인터켓, 스마트폰만큼이나 인류의 삶에 막대한 영향을 미칠 기술로 지목되는 AI인 만큼, 무분별한 AI 개발이 초래할 부작용에 대한 보다 많은 논의가 있으면 하는 바람입니다.

유럽연합(EU), 세계 최초로 인공지능(AI)법 가결

지난 13일(현지 시각), 인공지능(AI) 규제 법안인 AI 법이 유럽의회 본회의를 통과됐습니다. 유럽연합(EU)이 만든 이 법은 구속력을 가진 최초의 AI 규제법입니다. 전 세계 주요 선거를 앞두고 AI를

mkpark01.tistory.com

변화가 빠른 세상에서 살아남는 방법 (feat. 변해야 하는 나)

너무 빠르게 흘러가는 세상의 흐름에 정작 나의 중심을 잃고 사는 요즘이다. 늘 세미나 때마다 칭찬해 왔던 테슬라와 엔비디아가 상상을 초월할 정도의 위상으로 변모해 있다. 주가측면에서야

mkpark01.tistory.com

기술의 미래를 형성하는 최고의 영향력자 (feat. 생성형 AI)

인공지능과 인플루언서 마케팅의 교차점은 빠르게 진화하는 영역으로, 최고의 AI 인플루언서의 영향력이 상당한 영향력을 행사하고 있습니다. AI가 계속해서 기술의 윤곽을 재정의함에 따라 새

mkpark01.tistory.com

'기술' 카테고리의 다른 글

| 모건 스탠리 TMT(테크, 미디어 및 텔레콤) 컨퍼런스 (72) | 2024.03.27 |

|---|---|

| 인공지능(AI)으로 손 잡는 구글과 애플 (feat. 안드로이드와 iOS) (75) | 2024.03.24 |

| 유럽연합(EU), 세계 최초로 인공지능(AI)법 가결 (79) | 2024.03.21 |

| 변화가 빠른 세상에서 살아남는 방법 (feat. 변해야 하는 나) (74) | 2024.03.20 |

| 기술의 미래를 형성하는 최고의 영향력자 (feat. 생성형 AI) (75) | 2024.03.19 |

댓글